以前に書いた記事からだいぶ間が空いてしまったけど、

note103.hateblo.jp

今回はその続編というか、スピンオフ的な経過報告。

ちなみに、一つ前の記事でも本件の環境設定に関することを書いているので、よろしければどうぞ。

note103.hateblo.jp

今回の課題

前回の記事の主眼というのは、

- 録音した音声ファイルを聴きながら、Googleドキュメントの音声入力にシャドウイング*1で言葉を吹き込んでいくと、普通に文字起こしをするよりずっとラクにテキスト化できるじゃん!

- ……とか思ってたら、さらにSoundflowerというのを使えば自分でしゃべらなくても音声ファイルからダイレクトで文字起こしできるじゃん!!

みたいな話だったと思うのだけど*2、その後にいろいろな音声データでトライしてみたところ、綺麗に拾える場合と、誤認識が多くてカオスな状態になる場合とでバラバラというか、綺麗に拾える条件・法則がちょっとわかりづらかったので、今回は以下の観点から、その辺を整理してみたい。

- 再録音の有効性

- 再録音(元音声を聴きながらシャドウイングで新たな録音すること)は必要か?

- もし元の録音データのままでも使えるとすれば、どの程度の録音状態なら許容範囲か?

- 悪音質のデータを再録音したら、どの程度仕上がりが改善されるのか?

- 再録音した音声ファイルから音声入力をするのと、直接マイクに向かってしゃべりながら音声入力をするのとでは、どちらの方が精度が高いか?

- 音声入力時の再生速度の最適化

- 音声ファイルをGoogleドキュメントで音声入力させる際、再生速度は仕上がりテキストに影響を与えるか? もし与えるなら、最も綺麗にテキスト化されるスピードは?

- Googleドキュメントは最大で何分程度読み込み続けるのか?

1. 再録音の有効性

1-1. 再録音(元音声を聴きながらシャドウイングで新たな録音すること)は必要か?

結論から言うと、そこそこ綺麗に録音されているデータなら、再録音せずともある程度は正確に拾えるし、環境が整っているところで録音された音声ならば、なお良好な結果を得られると思う。

また、前回の記事でも示したように、英語の音声であれば日本語以上に綺麗にテキスト化されやすいようなので、たとえば英語のPodcastをテキスト化したい、といった場合にも再録音は不要かもしれない。

逆に、講演や会議、あるいは周りの音が一緒に入ってしまう場所でのインタビューなど、録音以外のことがメインになっている環境で録った音の場合、そのまま使うことはあまりお勧めできない。

実際には、そういったデータからでもテキスト化は成されるが、本来の内容との乖離が激しくなる可能性が高く、最初のテキスト化のコストを軽減できたとしても、そこから修正するコストが通常以上に高くなってしまい、かえって非効率になりかねない。

よって、そういった悪コンディションのデータを使う場合には、再録音、または後に示すように、直接しゃべり直しながら音声入力してしまった方が、トータルのコストを下げられるとは思う。

1-2. もし元の録音データのままでも使えるとすれば、どの程度の録音状態なら許容範囲か?

2種類のサンプルを用意してみた。

一つは、昨年のちょうど今頃にプログラミングの勉強会で発表をしたときの録音*3から、1分間だけ切り取ったもの。

2016-01-15_kichijojipm_sample by note103 | Free Listening on SoundCloud

もう一つは、自分のメインブログで時々公開している日記調のモノローグというか、Podcast風に淡々としゃべっている音声から、同じく1分間切り取ったもの。

2016-12-29_sample by note103 | Free Listening on SoundCloud

前者は広めの会議室のようなところで、自分の発表時にスライドを操作するPCの脇にICレコーダーを置いて録音している。

聴講席から他人の発表を録音するよりはクリアだが、それでもあまり良い音質とは言えない。

後者はAudacityというフリーのソフトウェアを使用して、ヘッドセットマイクから直接録音している。

よって、文字起こしを行うための録音としては良質な部類に入ると思う。

そして今回は、それぞれの音声を用いて音声入力をさせているところを、リアルタイムで動画に撮ってみた。

元の音声と仕上がりのテキストだけを提示するより、直感的に違いがわかるかもしれないと思ったので。

ちなみに、この動画撮影に際しては、音声ファイルの再生にExpressScribe*4、その音声を機械に聴かせるためにSoundflower、音声入力にはGoogleドキュメント(ブラウザはGoogle Chrome)、動画の録画にはQuickTime Playerを使用している。

以下では、まず動画だけ2パターン並べて示し、その後に仕上がりテキストを掲示する。

動画内で流れている音声は、そのときにGoogleドキュメントが聴いているのと同じものである。

動画比較

- 勉強会発表(会議室・ICレコーダーで)

- 20秒を過ぎてからは変化しなくなるのでそっ閉じ推奨。

- モノローグ(ヘッドセットマイクで)

- 上より少し音量が大きいので注意。

テキスト比較

- 勉強会発表(会議室・ICレコーダーで)

ちょっと待って勇気出してんですけどそれはただ死んだけど

(27文字)

- モノローグ(ヘッドセットマイクで)

後ね今回でスト掲示板に二つにページしかないんですがさっき言った400局から31局を経て最後の22曲になったって話があるんですけど31よりもちょっと多い70曲ぐらいですかねちょっと今正確に合わせていましたけど迷わ準決勝戦ぐらいの決勝戦が31から22に搾られる家庭だとした場合70キロから30局になる31分解中途半端ですけどね言いながら思いましたけどまたまた勝ったんですけどその70から31になるまでは準決勝みたいな感じが自分では下手ですねそのね70ぐらいまでをあの掲載してますので今回は

(242文字)

ということで、比べるまでもないほど前者はまったく拾えていない。

「メッセージはここで途切れている」みたいになっている。

後者の方はそれに比べるとだいぶ良い。というか、かなり違う。

それでふと気になったので、音声の波形も見てみた。

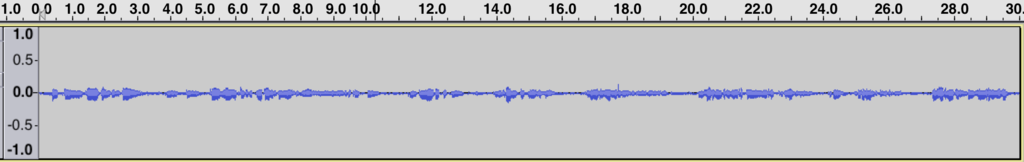

波形比較

上述のAudacityで、双方前半30秒分を切り出してみる。

なお、勉強会発表の方はICレコーダーのステレオ録音、モノローグはヘッドセットの1マイクなので、見比べやすいように前者はLだけを切り取った。

もしかすると音質以前の問題として、「ステレオはテキスト化されづらい。モノラルだとテキスト化されやすい」などの違いがあるのかな? とも思ったので、別途でICレコーダーのステレオ録音でモノローグを録ってみたが(マイクの近くで発声する)、これは綺麗にテキスト化されたので、ステレオとモノラルの違いはこの際とくに考慮しなくて良いと思う。

ではあらためて、波形の比較。

- 勉強会発表(会議室・ICレコーダーで)

- モノローグ(ヘッドセットマイクで)

別の話をしているので、山の場所が異なるのは当然のこととしても、それ以上に何より起伏の差がかなり違う。

だからどう、ということまでは言えないのだけど、まあ、「起伏の差が激しいとテキスト化されづらく、おとなしいとされやすい」ということなのかな、ぐらいの印象は持った。

で、このような結果を見ると、今度は以下のようなことが気になってくる。

1-3. 悪音質のデータを再録音したら、どの程度仕上がりが改善されるのか?

ということで、次はそれについて検証したい。

まずは先ほど惨憺たる結果をはじき出した、勉強会での発表内容を再録音する。

方法としては、ヘッドセットのヘッドホンからスロー再生で発表を聴きながら、同じヘッドセットのマイクからその内容を吹き込み直す。

ツールとしては、上記同様にヘッドホンへの出力にはExpressScribeを使用し、マイクからの録音にはAudacityを使う。

これが上でも何度か言っている「シャドウイング」というもので、とはいえ今回は元音声でぼくがかなり早口でしゃべってしまっているので、スロー再生を前提にセッティングしているが、シャドウイング自体は「音を聴きながら同じ言葉を発声する」ことができればよいので、このような環境がなければ「iPhoneからイヤホンで音を聴きながら口元で別のレコーダーに録音する」とかでも実現自体は可能である。

で、そのように再録音したものをGoogleドキュメントに読み込ませると、このようになる。

- 勉強会発表音声(再録音版)

- 仕上がりテキスト(再録音版)

でもう1個はまあよくあるこれもちょっとミスマッチがちかなっていう気がしているんですけどまあとりあえず4エラーお嫁様と出てるじゃんみたいなそれは正しいんだけどで後はまぁ確かにね英語はちょっとなじまないだろうけどとか言うんだけど英語が問題じゃないたぶんそれは多分エラーを読む人はそもそも何を読んでいるのかって言うと自分の頭で仮設がある程度できていてここでこけるって言うことはこれかこれかこれかそれかそれ以外かっていうのがあるわけですよねですそれと出てきたエラーをその前提と比べていると思うんですよだけど初心者っていうのはそれがもとの仮説がないから出てきたやつをもう最初から読んでいくしかないとだからたぶん日本語で出ても初心者にはわからないと思う日本語で言われても引数がどうだとかサブルーチンが不正な呼び出しをされていますとかしかもそれはちょっと違ったりとかするんで

(380文字)

ということで、元音声では30文字にも満たなかったのが嘘のように、大量かつ高い精度でテキスト化されている。*5

これだけ違いが出ると、ここでもまた波形を見たくなってくる。

で、取ってみた。

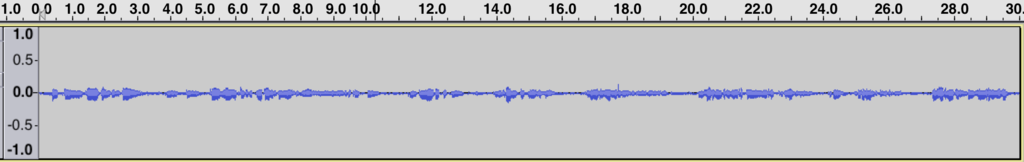

波形比較

まずは先ほどの、全然拾えなかったやつ。

- 勉強会発表(会議室・ICレコーダーで)

次に、再録音したらだいぶ拾えるようになったやつ。

- 勉強会発表(再録音版)

だいぶスリムになっている。

ついでに、先ほど綺麗に拾えたモノローグ音声も並べてみよう。

- モノローグ(ヘッドセットマイクで)

はい。まあ、とくにこれを分析できる知識はないのだけど、とはいえやはり、波形が激しいやつだと拾いづらいのかな、という感じはする。

ところで、先ほどの元音声と、再録音版とを聴き比べると、そのスピードが違うことが気になってくる。

どういうことかと言うと、再録音版がゆっくりしているのは、上記のようにシャドウイングする際の都合によるわけだけど、もしかすると元音声の方も再生速度を落としたらけっこう拾えるのでは? みたいな疑問が湧いたということ。

なので、念のために元音声の速度を落とした場合も試してみた。

- 勉強会発表音声(元音声・再生速度70%)

まったく反応ナシ……(なので途中で止めた)。

1-4. 再録音した音声ファイルから音声入力をするのと、直接マイクに向かってしゃべりながら音声入力をするのとでは、どちらの方が精度が高いか?

上記の検証により、音質の悪い音声ファイルでも、シャドウイングで再録音すれば音声入力によるテキスト化が可能になることがわかった。

しかしここで新たに気になるのが、一度別ファイルに再録音するのではなく、直接シャドウイングしながら音声入力ツールに吹き込んだらどうなるのか? ということだ。

というのも、別ファイルに再録音した場合、その後にGoogleドキュメントに読み込ませるときにもほぼ同じ時間をかけて読み込ませなければならないので、少なくとも元データの2回分(スロー再生で再録音するならばそれ以上)の時間がかかる。

翻って、再録音の工程を省いて直接音声入力してしまえば、その時間が半分で済む。

ということで、同じ勉強会の元音声を聴きながら、直接音声入力してみたのが以下。

- 勉強会発表音声(直接音声入力版)*6

- 仕上がりテキスト(直接音声入力版)

もう1個はまあよくあるこれもちょっとミスマッチがちかなっていう気がしているんですけどまあとりあえずエラー読めよと出てるじゃんみたいなそれは正しいんだけどで後はまぁ確かにね英語はちょっとなじまないだろうけどとか言うんだけど英語は問題じゃないたぶんそれは多分エラーを読む人がじゃあそもそも何を読んでいるのかって言うと自分の頭でも仮説がある程度できていてここでこけるって言うことはこれかこれかこれかそれかそれ以外かっていうのがあるわけですよねでそれと出てきたエラーをその前提と比べていると思うんですよねだけど初心者っていうのはそれがもとの仮説がないから出てきたやつをもう最初から読んでいくしかないとだからたぶん日本語で出ても初心者は分からない日本語で言われても引数がどうだとかサブルーチンが不正な呼び出しをされてますとかでしかもそれがちょっと違ったりとかまーするんで

(380文字)

ふむ。若干ながら、上の再録音版より精度が上がっているように見える。

拾った語数もほぼ同じ。

つまり、少なくともこの直接入力の方法が再録音版より劣るということはなさそうなので、もし最初からこの方法を採れるなら、その方が効率は良いかもしれない。

また、先に再録音だけを行う場合というのは、地味に「この発声でちゃんとテキスト化されるのか?」という不安が生じたり、かつ実際にその再録音したものを読み込ませてみたら上手くテキスト化されなかった、なんていうことも何度かあったりしたので、そのように結果が出るまで不安を抱えてしまうぐらいなら、最初から直接入力でフィードバックを確認しながらやったほうが精神的にラク、というメリットもあるかもしれない。

一方、これはあくまで個人的な実感だけど、この直接入力というのはなかなか疲れる。

上記のように、基本的には目の前で起こされていく状況を確認しながら進めることになるので、そうなると「音を聴きながら発声する」という作業に加え、「目視で仕上がりを確認する」という作業をマルチタスク的に抱えることになり、そのぶん肉体的な負担が増すのかもしれない。

また、直接音声入力をする際には、Googleドキュメントで文書を作成しながら録音を行える環境を整えなければならないので(マイクのセッティングなどはもちろん、他人の迷惑にならない場所へ移動するなど)、そうした「ちょうどよい環境」を作るコストが低くない。

その点、先に再録音を行ってから、別の機会に音声入力をするのであれば、トータルの作業時間は多くなるとしても、それぞれの特化的な作業に集中できるので、並行して一気にすべてを進めることに比べて負荷が低く、継続的な作業を見込める面もあると思う。

よって、この「再録音」と「直接入力」の選択に関しては、上記のようなメリット/デメリットを踏まえつつ、作業者それぞれの目的や、環境に応じて適した方法を選ぶのが良いように思える。

2. 音声入力時の再生速度の最適化

2-1. 音声ファイルをGoogleドキュメントで音声入力させる際、再生速度は仕上がりテキストに影響を与えるか? もし与えるなら、最も綺麗にテキスト化されるスピードは?

これについては、上記の再録音版データを「150%(速い)」「標準速度」「50%(遅い)」の3種類で読み込ませてみた。

(「標準速度」は前出のもの)

先に動画を3点並べ、その後に仕上がりテキストを並べて掲示する。

テキスト比較

- 再生速度150%

もう1個はまあよくあるこれもちょっとミスマッチがちかなっていう気がしているんですけどまあとりあえず予定はお嫁様と寝てるじゃんみたいなそれは正しいんだけどで後はまぁ確かにね英語はちょっとなじまないだろうけどとか言うんだけど英語が問題じゃないもんたぶんそれは多分エラーを読む人がそもそも何を読んでいるのかって言うと自分の頭で稼ぐがある程度できていてここでこけるって言うことがこれかこれかこれかこれかそれ以外かっていうのがあるわけですよねでそれと出てきたエラーをその前提と比べていると思うんですよだけど初心者っていうのはそれがもとの仮説がないから出てきたやつをもう退職から読んでいくしかないとだからたぶん日本語でても初心者にはわからないと思う日本語で言われても引数がどうだとかサブルーチン学生の呼び出しをされていますがしかもそれはちょっと違ったりとかするんで

(376文字)

- 再生速度100%(再掲)

でもう1個はまあよくあるこれもちょっとミスマッチがちかなっていう気がしているんですけどまあとりあえず4エラーお嫁様と出てるじゃんみたいなそれは正しいんだけどで後はまぁ確かにね英語はちょっとなじまないだろうけどとか言うんだけど英語が問題じゃないたぶんそれは多分エラーを読む人はそもそも何を読んでいるのかって言うと自分の頭で仮設がある程度できていてここでこけるって言うことはこれかこれかこれかそれかそれ以外かっていうのがあるわけですよねですそれと出てきたエラーをその前提と比べていると思うんですよだけど初心者っていうのはそれがもとの仮説がないから出てきたやつをもう最初から読んでいくしかないとだからたぶん日本語で出ても初心者にはわからないと思う日本語で言われても引数がどうだとかサブルーチンが不正な呼び出しをされていますとかしかもそれはちょっと違ったりとかするんで

(380文字)

- 再生速度50%

でもう1個はまあよくあるこれもちょっとミスマッチがちかなっていう気がしているんですけどまあとりあえずよヘラを読めよと出てるじゃんみたいなそれは正しいんだけどで後はまぁ確かにね英語はちょっと馴染まないだろうけどとか言うんだけど英語が問題じゃないたぶんそれは多分エラーを読む人はそもそも何を読んでいるのかって言うと自分の頭でか説がある程度できていてここでこけるっていうことはこれかこれかこれかそれかそれ以外かっていうのがあるわけですよねですそれと出てきたエラーをその前提と比べていると思うんですよだけど初心者っていうのはそれがもとの仮説がないから出てきたやつをもう最初から読んでいくしかないとだからたぶん日本語で出ても送信者には分からないと思う日本語で言われても引数がどうだとかサブルーチンが不正な呼び出しをされていますとかしかもそれはちょっと違ったりとかするんで

(380文字)

ということで、目視でこれらの違いを判別するのはけっこう大変なのだけど、ざっと読み取れるのは以下のようなこと。

- 拾える文字数はほぼ変わらない。

- 再生速度が速くても遅くても、それぞれ100%の場合に比べて誤認識が増えている。

- 150%: 「仮説」→「稼ぐ」、「最初」→「退職」

- 50%: 「エラー」→「ヘラ」、「初心者」→「送信者」

じつは事前の仮説としては、「スピードが遅いほど綺麗に起こされるのでは」と思っていたのだけど、実際には遅くすれば綺麗になるということはなく、むしろ読み込ませるのに余計時間がかかる分、デメリットの方が多いと思えた。

逆に、再生速度を速くしてもこのぐらいの誤認識で済むのであれば、それによって読み込む時間を短縮できるメリットを取った方が良いと考えることもできるが、とはいえこの段階でミスが多くなると、その後に行うテキスト編集(修正)の段階で手間や集中力といった負荷が増えるので、やはり誤認識は少なければ少ないほどよいとも思える。

よって、その辺りも含めて総合的に考えれば、標準速度(再生速度100%)にするのが無難かなと思うが、よくよく考えてみれば、再生速度が速すぎても遅すぎても、本来の人間がしゃべる言葉から離れていくことになるわけで、ようは「最も一般的な人間のしゃべり方に近い速度」を設定するのが良いということかもしれない。

また、そもそも人がしゃべる速度というのも人によって様々なわけで、ゆっくりしゃべっている音声ならやや速めに、逆に早口な人なら速度を落とすように、といった調整を行った方が綺麗に検知することもあるかもしれない。

2-2. Googleドキュメントは最大で何分程度読み込み続けるのか?

ところで、上記の動画群を見て気づいた人もいるかもしれないのだけど、前回の記事でぼくはこのようなことを書いていて、

4. 音声ファイルが終わるまで再読み込みなどのケア

前述のように、入力は音声ファイルが止まるまで続くわけではなく、途中で止まる。いわばフリーズしたような状態になる。

調子が良ければ1分以上入力され続けることもあるが、平均的には40秒程度かもしれない。

(略)

よって2秒程度入力が止まったら、もうフリーズしたとみなして再起動する。

具体的には、マイクボタンを押して一度入力機能をストップし、もう一度押して再開させる。すると、また入力が始まる。

しかし上の動画においては、そのような再起動は不要だった。

もしかすると、Googleの音声入力機能が向上したということだろうか?

よくわからないが、とりあえず現時点ではどの程度、再起動せずに動き続けるのか気になったので、これも試してみた。

といっても、そのためにわざわざ長尺の再録音をするのも面倒なので、上で元音声のままでもそこそこの精度でテキスト化された、モノローグ音声のフル尺版(約11分半)を読み込ませてみた。

結果はこのような感じ。*7

なんと音声ファイルが終わるまでの11分半、すべて再起動なしで読み込んでしまった。

じつはブラウザの拡張機能でiMacrosというツールを使うと、一定時間ごとに任意の処理をさせることができて、それを設定すれば数分ごとに音声の読み込みを再起動させることができるので、いずれその方法も紹介しようと思っていたのだけど、これならもはや不要かもしれない。

経験上、この音声入力機能は音を読み込めない時間がしばらく続くとストップしてしまうようなので、切れ目なく読み込める程度に音質が良いファイルなら、再起動の必要性が低くなったということなのかもしれないが。

まとめ

例によって長くなってしまったけど、最初に掲げた課題については触れ終えたので、ひとまずここまでのまとめ。

- 再録音の有効性

- Q1: 再録音(元音声を聴きながらシャドウイングで新たな録音すること)は必要か?

- A1: 録音状態が良ければ不要な場合もある。ただし誤認識が多ければそのぶん後の作業に負債を抱え込むことになるので、後のことまで考えて判断すべし。録音状態が悪ければ再録音一択。

- Q2: もし元の録音データのままでも使えるとすれば、どの程度の録音状態なら許容範囲か?

- A2: 講演会場や会議室など広い空間におけるICレコーダー等での録音は、そのままでは使えない可能性が高い。一方、マイクと発声源が近い録音ならば良好な結果を得られる可能性が高い。

- Q3: 悪音質のデータを再録音したら、どの程度仕上がりが改善されるのか?

- A3: まったくテキスト化されなかったものが、かなりテキスト化されるようになる。

- Q4: 再録音した音声ファイルから音声入力をするのと、直接マイクに向かってしゃべりながら音声入力をするのとでは、どちらの方が精度が高いか?

- A4: 直接しゃべりながら音声入力を行った方が、精度が高くなると思われる。この場合、再録音の工程をスキップできるので、作業時間の短縮というメリットもある。ただし、工程を分ければ環境を準備しやすくなったり、作業負荷を軽減できたりするメリットもあるので、状況に応じて判断すべし。

- 音声入力時の再生速度の最適化

- Q5: 音声ファイルをGoogleドキュメントで音声入力させる際、再生速度は仕上がりテキストに影響を与えるか? もし与えるなら、最も綺麗にテキスト化されるスピードは?

- A5: 1分のサンプルデータで確認したかぎり、再生速度による大きな違いはないが、その中では標準速度の仕上がりが一番良いように見える。ただし、元音声の発話速度によって、チューニングの余地があるかもしれない。要検証。

- Q6: Googleドキュメントは最大で何分程度読み込み続けるのか?

- A6: 以前に試した際は40秒〜1分程度ごとの再起動が必要だと感じたが、今回試したところでは10分以上にわたるノンストップの入力が実現した。ただし、音質が良好であるという条件が必要かもしれず、その他にも長時間入力を実現させるための条件があるかもしれない。要検証。

免責事項

今回行った各種の実験は、限られたサンプルと機会を通じて、それぞれ1〜2度ずつ試してみたものに過ぎないので、普遍的な正解ではまったくない。

再現性の高い結論を出すためには、より厳密に条件を揃えた上で、同じ実験をくり返し行うべきだが、さすがにそこまではできないし、そもそもこのツール自体どんどんアップデートされていくだろうし、あるいは突然使えなくなってしまう可能性だってある。

あくまで一人のユーザーが、個人的・自主的にいろいろ遊んでみた結果として見てもらえたらありがたい。

次回予告

前回の最後で、textlintの導入について予告したのだけど、それ以前の音声入力関連の情報をまとめるだけで力尽きてしまった。

textlintの使用を含む、「テキスト整形」に関わる作業については、次回以降にあらためてまとめてみたい。

(いつになるかは無保証だが……)

*1:耳から入った音声を追いかけるように発声すること。語学の学習などでよく行われるらしい。

*2:もう半年前の記事で自分でも忘れかけていたので、この部分を書きながら少しずつ思い出した。

*3:元資料などはここで読める。→ 吉祥寺.pm6に参加しました(トーク音声公開&スライド作成方法) - the code to rock

*4:音声の再生はiTunesなど他の汎用音楽ソフトでも可能だが、ここでは細かいショートカットキーの設定が便利なのでExpressScribeを使った。

*5:不思議なことに、というか、皮肉なことに、というか、この再録音版は、人間の耳で聞くと、元の音声よりぎこちない調子で、けっして聞き心地が良いとは言えないのだけど、機械にとってはこちらの方が聞きやすいようである。これが人間にとって聞きづらく感じられる理由は、この音声がシャドウイングという、「発声し直すこと」を目的に録音されているからであって、言い換えれば、「人間に話の内容を理解してもらうこと」を目的にはしていないからだと考えられる。つまり、想定リスナーは「人間ではない何か」である。そのような音声が人間からは親しみを持たれづらく、しかし機械からは理解(というか解釈)されやすい、という状況が面白い。

*6:メインの発話の後ろで薄く聞こえている声があるが、これはヘッドホンから漏れている元音声。シャドウイングは耳から入る音に集中して、自分の発声はあまり聞こえないようにした方がやりやすい、という話を時々聞くけど、まさにそんな感じがしたのでヘッドホンの音量を大きめにしていた。

*7:実験の目的上、仕上がりテキストは不要なので動画のみ掲示するが、通読できる程度まで整形したテキストはここで読める。→ 音声入力を用いた文字起こしでブログ(3) 〜schola16巻のつくり方〜 - 103